Introdução

De uma maneira bem simples, uma Rede de Computadores pode ser e muitas vezes é definida como uma estrutura de computadores e dispositivos que se conectam através de um sistema de comunicação com o objetivo de trocarem informações e recursos entre si. Essa interligação permite que os dispositivos compartilhem arquivos, utilizem a mesma conexão com a internet, acessem servidores e até mesmo utilizem periféricos, como impressoras, de forma remota.

As redes podem ser classificadas de diferentes maneiras, dependendo de sua abrangência e funcionalidade. As redes locais (LANs) são aquelas que cobrem áreas limitadas, como residências, escritórios e escolas, enquanto as redes de longa distância (WANs) conectam sistemas espalhados por cidades, países ou até continentes, como é o caso da própria internet. Além disso, existem redes sem fio, como o Wi-Fi, que dispensam o uso de cabos e oferecem maior flexibilidade na conexão dos dispositivos.

Para que uma rede funcione corretamente, são utilizados protocolos de comunicação, como o TCP/IP, que garantem que os dados sejam enviados e recebidos de maneira eficiente e segura. Equipamentos como roteadores, switches e servidores desempenham papéis essenciais na transmissão e gerenciamento das informações dentro da rede.

Com o avanço da tecnologia, as redes de computadores evoluíram significativamente e se tornaram fundamentais no dia a dia, viabilizando desde o acesso à internet até a comunicação entre dispositivos inteligentes e sistemas corporativos. O crescimento da Internet das Coisas (IoT) e da computação em nuvem reforça ainda mais a importância das redes na sociedade moderna, garantindo conectividade e integração entre pessoas, empresas e serviços em escala global.

Um pouco de História

A história das redes de computadores tem suas origens ligadas ao contexto da Guerra Fria, quando os Estados Unidos buscavam formas de proteger suas comunicações contra possíveis interceptações inimigas. Em 1958, o governo americano criou a ARPA (Advanced Research Projects Agency), atualmente conhecida como DARPA (Defense Advanced Research Projects Agency), em resposta ao lançamento do Sputnik, o primeiro satélite artificial colocado em órbita pela União Soviética em 1957. Essa disputa tecnológica marcou o início da corrida espacial e incentivou avanços em diversas áreas, incluindo a comunicação digital. Entre 1968 e 1969, o pesquisador Lawrence Roberts, junto com a ARPA, desenvolveu a ARPANET (Advanced Research Projects Agency Network), a primeira rede de computadores do mundo. Inicialmente projetada para transmitir dados militares sigilosos, a ARPANET também interligava instituições de pesquisa nos Estados Unidos, facilitando o compartilhamento de informações e recursos computacionais.

A ARPANET implementou uma grande melhoria ao adotar a comutação de pacotes, um modelo que revolucionou a forma como os dados eram transmitidos nas redes de computadores. Antes disso, a comunicação seguia o modelo de comutação de circuitos, como nas redes telefônicas tradicionais, onde uma conexão exclusiva era estabelecida entre dois pontos antes da transmissão dos dados. Esse método, embora confiável, desperdiçava recursos, pois mantinha o canal ocupado mesmo quando não havia troca ativa de informações.

Com a comutação de pacotes, os dados passaram a ser divididos em pequenos blocos chamados pacotes, que são enviados separadamente pela rede, podendo seguir caminhos diferentes até chegarem ao destino. No receptor, os pacotes são reorganizados na ordem correta para reconstruir a mensagem original. Esse sistema tornou a transmissão de dados mais eficiente, pois otimizava o uso da rede, permitindo que múltiplos dispositivos compartilhassem os mesmos canais sem a necessidade de reservar uma conexão fixa. Além disso, aumentou a tolerância a falhas, pois, se um caminho estivesse congestionado ou inoperante, os pacotes poderiam ser redirecionados automaticamente por outra rota.

Essa tecnologia foi fundamental para a evolução das redes modernas, influenciando diretamente o desenvolvimento do protocolo TCP/IP mais tarde, que se tornou a base da internet.

Hoje, a comutação de pacotes é usada em praticamente todas as redes digitais, garantindo a eficiência e a escalabilidade da comunicação global.

Nos anos 1970, a ARPANET continuou a crescer, conectando mais universidades e centros de pesquisa. No entanto, para que os computadores pudessem se comunicar de forma eficiente, era necessário um conjunto de regras padronizadas. Foi nesse contexto que surgiram os protocolos de comunicação, com destaque para o desenvolvimento do TCP/IP (Transmission Control Protocol / Internet Protocol), criado por Vinton Cerf e Robert Kahn.

Em 1973, o TCP/IP começou a ser testado na ARPANET e, em 1º de janeiro de 1983, tornou-se o protocolo oficial da rede. Essa mudança foi fundamental para a evolução das redes, pois estabeleceu a base para o que viria a ser a internet. Com o TCP/IP, qualquer computador ou sistema compatível poderia se conectar a outras redes, expandindo as possibilidades de comunicação globalmente. Esse período também marcou o surgimento das primeiras redes além da ARPANET, como a NSFNET, financiada pela National Science Foundation, que ajudou a expandir a conectividade para instituições acadêmicas nos Estados Unidos.

Na década de 1980, com a popularização dos computadores pessoais e a necessidade de conectar máquinas dentro de empresas e universidades, surgiram as redes locais (LANs – Local Area Networks). Essas redes permitiam que computadores próximos compartilhassem arquivos, impressoras e outros recursos de forma mais rápida e eficiente.

Entre as principais tecnologias desenvolvidas para LANs, destacam-se o Ethernet, criado por Robert Metcalfe na Xerox PARC, e o Token Ring, desenvolvido pela IBM. O Ethernet rapidamente se tornou o padrão dominante, devido à sua simplicidade, baixo custo e eficiência. Paralelamente, surgiram as redes metropolitanas (MANs), que conectavam diferentes prédios ou campi universitários, e as redes de longa distância (WANs), que interligavam sistemas em diferentes regiões geográficas. Enquanto isso, a NSFNET, que já havia sido criada nos anos 1970, começou a se expandir e substituir a ARPANET como a principal rede de pesquisa, preparando o terreno para o crescimento da internet comercial no início dos anos 1990.

Com o avanço do século XXI, as redes se tornaram mais rápidas, seguras e acessíveis. A chegada do Wi-Fi, da fibra óptica e das conexões móveis, como 4G e 5G, revolucionaram a forma como as pessoas e dispositivos se conectam. Hoje, a evolução das redes inclui conceitos como computação em nuvem, redes definidas por software (SDN) e a expansão da Internet das Coisas (IoT), permitindo a comunicação entre bilhões de dispositivos ao redor do mundo.

Evolução das Redes

As redes de computadores passaram por diversas transformações ao longo do tempo, evoluindo para atender às crescentes demandas de comunicação e eficiência. Antes da introdução dos dispositivos de interconexão, a comunicação entre computadores era realizada por meio de conexões ponto a ponto, limitadas em escalabilidade e desempenho. Esse modelo dificultava a expansão e a confiabilidade das redes.

Uma das primeiras formas de organização das redes locais foi a topologia de barramento, na qual todas as máquinas eram conectadas a um único cabo coaxial central (backbone). A comunicação era feita compartilhando esse meio físico, o que limitava o número de dispositivos e podia causar colisões de dados. Para conectar novos dispositivos ao cabo coaxial sem cortá-lo, era utilizado um transceptor-vampiro, que perfurava a blindagem do cabo para alcançar o núcleo condutor e permitir a conexão. Essa abordagem permitia a expansão da rede, mas apresentava desvantagens, como degradação do sinal e dificuldades na reconfiguração.

A topologia de barramento tinha alta perda de dados devido a colisões de pacotes. Como todas as máquinas compartilhavam o mesmo meio físico, quando dois dispositivos tentavam transmitir simultaneamente, ocorria uma colisão, resultando em retransmissões e degradando o desempenho da rede. Para minimizar esse problema, utilizava-se o protocolo CSMA/CD (Carrier Sense Multiple Access with Collision Detection), que detectava colisões e programava retransmissões após um tempo aleatório, mas isso ainda limitava a escalabilidade e eficiência da rede.

O hub foi um dos primeiros dispositivos de interconexão utilizados para centralizar conexões em redes locais (LANs). Ele operava na camada física do modelo OSI e simplesmente retransmitia os dados recebidos para todos os dispositivos conectados, independentemente do destino. Isso gerava um alto número de colisões de pacotes e impactava negativamente o desempenho da rede.

A introdução dos switches revolucionou as redes locais. Diferente dos hubs, os switches operam na camada de enlace de dados e encaminham os pacotes apenas para o dispositivo de destino correto, reduzindo colisões e melhorando significativamente a eficiência da comunicação. Com o avanço da tecnologia, os switches modernos passaram a oferecer funcionalidades avançadas, como suporte a VLANs, Qualidade de Serviço (QoS) e redes definidas por software (SDN), tornando-se essenciais para a infraestrutura de redes corporativas e data centers.

Transmissão de Dados

A transmissão de dados é o processo de envio e recepção de informações entre dispositivos em uma rede de computadores. Esse processo ocorre por meio de sinais elétricos, ópticos ou eletromagnéticos, dependendo do meio de comunicação utilizado. A transmissão de dados pode ocorrer de três formas: simplex, half-duplex e full-duplex, dependendo da direção e simultaneidade do fluxo de informações entre os dispositivos.

Na transmissão simplex, os dados fluem em apenas uma direção, sem possibilidade de resposta. Um exemplo clássico é a comunicação entre um teclado e um computador, onde as teclas enviam sinais ao sistema, mas não recebem dados de volta. Outro exemplo são as transmissões de rádio e televisão, onde o emissor envia sinais, mas não recebe retorno dos receptores.

Na transmissão half-duplex, os dados podem ser enviados em ambas as direções, mas apenas um dispositivo pode transmitir por vez. Isso significa que, enquanto um dispositivo está enviando, o outro precisa esperar para responder. Um exemplo prático é o uso de rádios comunicadores (walkie-talkies), onde uma pessoa fala enquanto a outra escuta, e a comunicação alterna entre os dois lados.

O full-duplex permite que os dados sejam transmitidos simultaneamente nos dois sentidos, como ocorre em chamadas telefônicas, onde ambas as pessoas podem falar e ouvir ao mesmo tempo.

Além disso, a transmissão pode ser síncrona ou assíncrona, dependendo da forma como os dados são organizados e enviados. Na transmissão síncrona, os dados são enviados continuamente em blocos ou fluxos, seguindo um sinal de sincronização compartilhado entre o emissor e o receptor. Isso significa que ambos os lados operam no mesmo ritmo, garantindo uma comunicação eficiente e rápida. Esse tipo de transmissão é usado em conexões de alta velocidade, como redes Ethernet e fibra óptica.

Já na transmissão assíncrona, os dados são enviados de forma intermitente, sem um sinal de sincronização contínuo. Cada unidade de informação contém marcas de início e fim para que o receptor possa identificá-las corretamente. Esse método é mais simples e flexível, sendo utilizado em comunicações onde os dados não precisam ser transmitidos constantemente, como em teclados e conexões seriais tradicionais (RS-232).

Os meios de transmissão podem ser guiados, como cabos de cobre (Ethernet) e fibra óptica, ou não guiados, como redes sem fio (Wi-Fi, Bluetooth, 4G/5G). Em redes cabeadas, os sinais viajam por condutores físicos, enquanto nas redes sem fio os dados são transmitidos por ondas de rádio ou luz infravermelha.

A velocidade da transmissão de dados é medida em bits por segundo (bps) e pode variar conforme a tecnologia utilizada.

A perda de pacotes por colisão era um problema em redes half-duplex, especialmente nas antigas redes Ethernet baseadas em hub. Nessas redes, como a transmissão ocorria em ambos os sentidos, mas apenas um dispositivo podia enviar dados por vez, ocorria colisão quando dois dispositivos tentavam transmitir ao mesmo tempo. Para resolver isso, o protocolo CSMA/CD (Carrier Sense Multiple Access with Collision Detection) foi implementado, permitindo que os dispositivos verificassem o canal antes de enviar dados e retransmitissem caso houvesse uma colisão.

Hoje, com o uso de switches e redes full-duplex, as colisões foram praticamente eliminadas, pois cada dispositivo pode enviar e receber dados simultaneamente em canais dedicados.

Formas de transmitir dados

Os dados podem ser transmitidos por meio de duas principais abordagens: comutação de circuitos e comutação de pacotes. Na comutação de circuitos, antes do início da comunicação, é estabelecido um caminho dedicado entre o emissor e o receptor, garantindo uma taxa de transmissão constante. Esse método era muito utilizado em redes telefônicas tradicionais, mas pode ser ineficiente para tráfego esporádico, pois mantém os recursos alocados mesmo quando não há transmissão ativa.

Já na comutação de pacotes, os dados são divididos em pequenos blocos chamados pacotes antes de serem enviados. Cada pacote pode seguir por diferentes rotas na rede e ser remontado no destino. Esse método é mais eficiente, pois permite um melhor aproveitamento da largura de banda. A comutação de pacotes pode operar de duas formas: no modo de datagrama, em que cada pacote é tratado de forma independente e pode seguir caminhos distintos, ou no modo de circuito virtual, em que um caminho lógico é estabelecido antes da transmissão, garantindo que os pacotes cheguem na ordem correta.

Esse último modelo combina algumas vantagens da comutação de circuitos com a flexibilidade da comutação de pacotes. A Internet, baseada no protocolo TCP/IP, utiliza majoritariamente a comutação de pacotes, pois esse método é mais adaptável às variações de tráfego e permite uma melhor escalabilidade.

Sinais elétricos

Os sinais elétricos são a base da comunicação em redes de computadores e podem ser classificados em sinais analógicos e digitais. Os sinais analógicos variam de forma contínua ao longo do tempo, podendo assumir um número infinito de valores dentro de um intervalo. Eles são utilizados em sistemas como rádio e telefonia convencional. Já os sinais digitais possuem valores discretos, geralmente representados por dois níveis distintos, como 0 e 1, sendo amplamente utilizados em computadores e redes modernas.

Para transmitir informações por meio de sinais elétricos, é necessário utilizar um meio físico, que pode ser fios de cobre, fibras ópticas ou ondas de rádio. Nos fios de cobre, os dados são transmitidos por variações na voltagem ou corrente elétrica. Na fibra óptica, a transmissão ocorre por meio de pulsos de luz que representam os dados binários. No caso das ondas de rádio, os sinais eletromagnéticos são modulados para transportar a informação pelo ar.

A transmissão de sinais pode ser afetada por interferências, atenuação e ruído. A atenuação é a perda de intensidade do sinal à medida que ele se propaga no meio de transmissão, o que pode exigir o uso de amplificadores ou repetidores. O ruído consiste em variações indesejadas no sinal, que podem ser causadas por interferências eletromagnéticas, dificultando a recepção correta da informação. Para minimizar erros na transmissão, são utilizados métodos de codificação e técnicas de correção de erro, garantindo que os dados sejam interpretados corretamente pelo receptor.

Codificação de Sinais Elétricos

A codificação de sinais elétricos é o processo de transformar informações em variações de tensão ou corrente para que possam ser transmitidas por um meio físico, como um cabo de cobre. Essa codificação pode ser analógica ou digital, dependendo da forma como os sinais variam no tempo.

No caso da codificação analógica, a tensão elétrica varia de forma contínua dentro de um intervalo de tempo. Se estivermos transmitindo um sinal de áudio, por exemplo, a tensão do cabo pode oscilar entre -1V e 1V seguindo exatamente a forma da onda sonora original. Isso significa que qualquer variação na voz resulta em uma mudança correspondente na voltagem transmitida. Como esse tipo de sinal pode assumir infinitos valores dentro de um intervalo de tempo, ele é muito suscetível a ruídos e degradação ao longo da transmissão.

Já na codificação digital, os sinais assumem apenas valores discretos, geralmente dois níveis bem definidos, como 0V para representar "0" e 5V para representar "1". A principal vantagem disso é a maior resistência a ruídos, pois pequenas variações de tensão não impedem a correta interpretação dos bits. Dentro da codificação digital, existem diferentes formas de organizar os sinais para facilitar a transmissão e evitar erros:

NRZ (Non-Return-to-Zero): Nesse esquema, a tensão mantém um nível constante durante todo o tempo de um bit. Se for "1", pode ser 5V, e se for "0", pode ser 0V. O problema desse método é que sequências longas de "0s" ou "1s" podem dificultar a sincronização entre transmissor e receptor.

Manchester: Resolve o problema de sincronização inserindo uma transição de nível no meio de cada bit. Se for "1", a transição vai de baixo para cima; se for "0", vai de cima para baixo. Isso garante que o receptor sempre detecte mudanças, facilitando a recuperação do sinal.

4B/5B: Para aumentar a eficiência, esse método transforma grupos de 4 bits em 5 bits, garantindo que sempre haja transições suficientes para evitar problemas de sincronização.

O tipo de codificação escolhido depende do meio de transmissão e do nível de confiabilidade necessário. Em redes locais como Ethernet, por exemplo, é comum o uso da codificação Manchester ou variantes mais eficientes para garantir que os sinais sejam transmitidos e interpretados corretamente.

Meios de transmissão

Os meios de transmissão são os canais físicos pelos quais os dados trafegam em uma rede. Eles podem ser classificados em guiados e não guiados, dependendo se o sinal segue um caminho físico específico ou se a propagação é livre pelo espaço.

Nos meios guiados, a transmissão ocorre através de cabos físicos que direcionam o sinal. O cabo de par trançado é um dos mais comuns, sendo utilizado em redes Ethernet. Ele pode ser não blindado (UTP) ou blindado (STP), e sua principal característica é a torção dos fios para reduzir interferências eletromagnéticas.

Outro meio guiado é o cabo coaxial, que possui uma estrutura de blindagem eficiente contra interferências, sendo utilizado em redes mais antigas e em sistemas de televisão a cabo. Já a fibra óptica utiliza pulsos de luz em vez de sinais elétricos, permitindo altas taxas de transmissão com baixa perda de sinal. Existem dois tipos principais de fibra óptica: monomodo, ideal para longas distâncias, e multimodo, usada para conexões mais curtas.

Nos meios não guiados, os dados são transmitidos por ondas eletromagnéticas que se propagam pelo ar, sem um caminho físico definido. As ondas de rádio são amplamente utilizadas em redes Wi-Fi e celulares, variando de frequência para atender diferentes aplicações. A transmissão por micro-ondas é usada para enlaces de longa distância e requer visada direta entre as antenas. Já a transmissão por infravermelho é usada em aplicações de curto alcance, como controles remotos, mas não atravessa obstáculos.

Desempenho em comutação de pacotes

Em redes de comutação de pacotes, o desempenho da transmissão de dados é afetado por três fatores principais: atraso, perda e vazão.

O atraso representa o tempo necessário para que um pacote percorra o caminho entre o emissor e o receptor. Ele pode ser dividido em quatro componentes principais: atraso de processamento, que ocorre nos roteadores ao analisar o cabeçalho e encaminhar o pacote; atraso de fila, que acontece quando o pacote precisa esperar na fila do roteador antes de ser enviado; atraso de transmissão, que é o tempo necessário para enviar todos os bits do pacote ao meio de transmissão, dependendo da taxa de transmissão do enlace; e atraso de propagação, que é o tempo que o sinal leva para viajar pelo meio físico até o próximo nó, dependendo da distância e da velocidade de propagação do meio utilizado.

A perda de pacotes acontece quando um pacote não chega ao seu destino, normalmente devido ao congestionamento em um roteador. Quando a fila de espera de um roteador atinge sua capacidade máxima, pacotes novos podem ser descartados. Essa perda pode ser minimizada por mecanismos de retransmissão, como os usados pelo protocolo TCP, ou por esquemas de controle de congestionamento.

A vazão refere-se à quantidade de dados transmitidos com sucesso por unidade de tempo, geralmente medida em bits por segundo (bps). Ela pode variar dependendo da taxa de transmissão dos enlaces e da presença de congestionamento na rede. O desempenho final percebido pelo usuário depende da vazão fim a fim, que pode ser limitada pelo enlace mais lento no caminho entre a origem e o destino.

O desempenho em comutação de pacotes envolve métricas como jitter, ping e perda de pacotes, mas também considera outros fatores como atraso e vazão, explicados acima. O ping é uma ferramenta que mede o atraso fim a fim, ou seja, o tempo necessário para que um pacote viaje até um destino e retorne. Esse atraso pode ser influenciado por diferentes fatores, incluindo o tempo de processamento nos roteadores, filas de espera e a distância física entre os dispositivos.

O jitter refere-se à variação no atraso dos pacotes. Em uma rede ideal, os pacotes chegam ao destino em intervalos regulares. No entanto, congestionamento, roteadores sobrecarregados ou caminhos variáveis podem fazer com que alguns pacotes cheguem mais rápido que outros, o que pode ser problemático para aplicações em tempo real, como chamadas de voz e streaming de vídeo.

A perda de pacotes ocorre quando pacotes são descartados antes de chegar ao destino, geralmente devido a congestionamento ou erros na transmissão. Em redes que utilizam TCP, a perda de pacotes pode resultar em retransmissões, aumentando ainda mais o atraso.

Além dessas métricas, o desempenho também é avaliado pela vazão, que representa a taxa efetiva de transmissão de dados entre origem e destino. Redes congestionadas podem apresentar baixa vazão, mesmo que a capacidade teórica da conexão seja alta.

Tipos de Redes de Computadores

Os tipos de redes de computadores podem ser classificados de acordo com sua abrangência geográfica, arquitetura e forma de conexão. A divisão mais comum leva em conta o alcance físico da rede e sua estrutura de comunicação.

Local Area Network - LAN

Uma LAN (Local Area Network) é uma rede que conecta computadores e dispositivos dentro de um espaço limitado, como uma casa, escritório ou prédio. Seu objetivo é permitir a comunicação e o compartilhamento de recursos, como arquivos, impressoras e internet.

Quando usamos um roteador em casa, criamos uma LAN, onde todos os dispositivos conectados ao Wi-Fi fazem parte dessa mesma rede. As LANs podem ser cabeadas, usando cabos Ethernet para maior estabilidade, ou sem fio (WLAN), utilizando Wi-Fi para mais flexibilidade.

Metropolitan Area Network - MAN

Uma MAN (Metropolitan Area Network) é uma rede que cobre uma área maior que uma LAN, como uma cidade ou um campus universitário, conectando múltiplas redes locais dentro dessa região. Ela é usada por empresas, órgãos públicos e instituições que precisam interligar filiais ou prédios sem depender da internet pública.

Um exemplo comum é a infraestrutura de telecomunicações que conecta escolas, hospitais e prédios governamentais dentro de uma cidade. Essas redes podem ser privadas ou operadas por provedores de serviços para oferecer acesso à internet de alta capacidade.

Wide Area Network - WAN

Uma WAN (Wide Area Network) é uma rede que cobre grandes distâncias, conectando dispositivos e redes locais (LANs) em diferentes cidades, países ou até continentes. A internet é o maior exemplo de uma WAN, interligando computadores e servidores no mundo todo.

Diferente das LANs e MANs, que operam em áreas menores, as WANs utilizam diversas tecnologias para transmissão de dados, como cabos submarinos, satélites e redes de fibra óptica. Empresas e governos usam WANs para conectar filiais em diferentes locais, garantindo comunicação e acesso remoto a sistemas centralizados. Como cobrem longas distâncias, as WANs geralmente têm maior latência e dependem de provedores de telecomunicações para funcionamento.

Personal Area Network - PAN

Uma PAN (Personal Area Network) é uma rede de curto alcance que conecta dispositivos próximos a um único usuário, geralmente dentro de alguns metros. Um exemplo comum é a conexão entre um smartphone e um smartwatch via Bluetooth, permitindo a troca de dados sem a necessidade de cabos.

Outros exemplos incluem fones de ouvido sem fio, teclados e mouses conectados a um computador, além de dispositivos como pulseiras fitness e assistentes virtuais. As PANs podem ser cabeadas, como na conexão de um smartphone a um computador via USB, ou sem fio, utilizando tecnologias como Bluetooth, NFC e Wi-Fi Direct. Elas são projetadas para comunicação rápida e eficiente entre dispositivos pessoais.

Neighborhood Area Network - NAN

Uma NAN (Neighborhood Area Network) é uma rede que cobre uma área maior que uma LAN, mas menor que uma MAN, sendo projetada para conectar dispositivos dentro de um bairro ou pequena comunidade. Ela é frequentemente utilizada em projetos de cidades inteligentes, onde sensores, câmeras de segurança e sistemas de iluminação pública se comunicam para otimizar serviços urbanos.

As NANs também são comuns em redes de provedores de internet locais, permitindo que múltiplas residências compartilhem uma mesma infraestrutura de conexão. Elas geralmente utilizam fibra óptica, redes sem fio de longo alcance (como WiMAX) ou tecnologias de malha (mesh) para garantir comunicação eficiente entre os dispositivos da área.

Tipos de Infraestrutura

A infraestrutura de redes pode ser classificada com base na forma como os dispositivos e sistemas são organizados para permitir a comunicação e o compartilhamento de recursos. Os principais tipos incluem infraestrutura física, infraestrutura virtual, infraestrutura baseada em nuvem e infraestrutura híbrida.

A infraestrutura física envolve os componentes tangíveis da rede, como cabos, roteadores, switches, servidores e data centers. Essa infraestrutura pode ser cabeada, utilizando fibra óptica ou cabos Ethernet, ou sem fio, como redes Wi-Fi e conexões móveis (4G/5G). Ela é a base de qualquer rede, garantindo a transmissão de dados entre os dispositivos.

A infraestrutura virtual abstrai os componentes físicos e permite a criação de redes definidas por software, como as SDNs (Software-Defined Networks), onde o controle da rede é gerenciado de forma centralizada. Essa abordagem melhora a flexibilidade e a automação, reduzindo a dependência de hardware específico.

A infraestrutura baseada em nuvem utiliza data centers remotos para hospedar e gerenciar serviços de rede. Empresas podem terceirizar servidores, armazenamento e processamento para provedores como AWS, Google Cloud e Microsoft Azure, reduzindo custos operacionais e aumentando a escalabilidade.

A infraestrutura híbrida combina elementos físicos, virtuais e em nuvem para otimizar o desempenho e a segurança da rede. Muitas empresas adotam essa abordagem para manter parte dos serviços locais (on-premises) e integrar soluções em nuvem conforme necessário, garantindo maior flexibilidade e controle sobre seus sistemas.

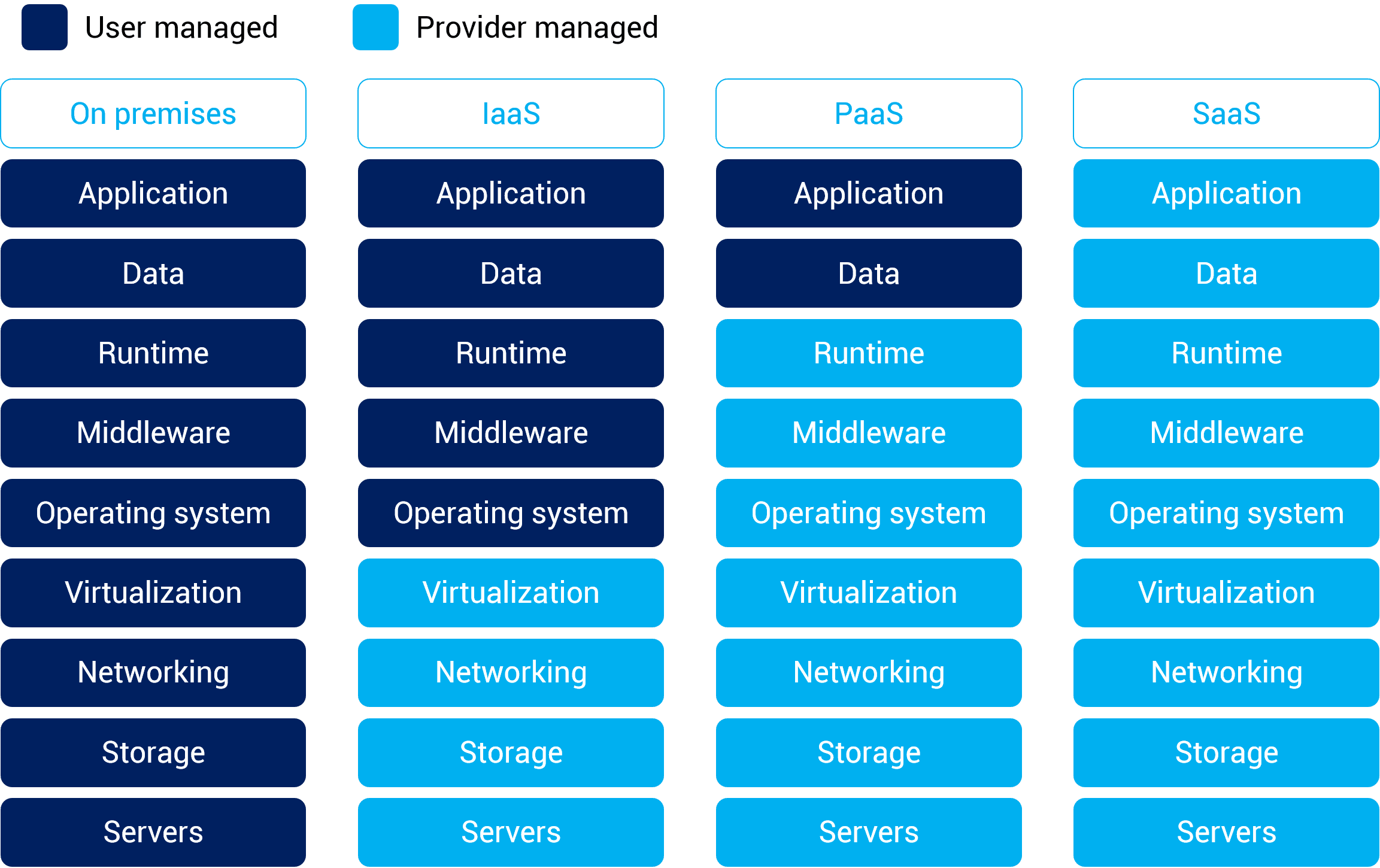

SaaS - Software as a Service

È um modelo onde o usuário acessa softwares e aplicativos diretamente pela internet, sem precisar instalar ou gerenciar infraestrutura. Exemplos incluem Gmail, Google Drive, Microsoft 365 e Netflix. Nesse modelo, tudo – servidores, armazenamento, rede e software – é gerenciado pelo provedor, permitindo que o usuário foque apenas no uso da aplicação.

Os tipos são: Spotify, Youtube Premium, Office 365, One Drive, Google Drive, iCloud, dentre muitos outros.

PaaS - Plataform as a Service

Oferece uma plataforma completa para desenvolvimento, hospedagem e gerenciamento de aplicativos sem a necessidade de gerenciar infraestrutura de servidores e sistemas operacionais. É voltado para desenvolvedores que querem focar na criação de aplicações sem se preocupar com a configuração de servidores. Exemplos incluem Google App Engine, Microsoft Azure App Services e Heroku.

IaaS - Infrastructure as a Service

Fornece recursos de infraestrutura sob demanda, como servidores virtuais, armazenamento e redes, permitindo que empresas criem e gerenciem seus próprios ambientes de TI sem precisar investir em hardware físico. Esse modelo dá mais controle ao usuário, que pode configurar sistemas operacionais, segurança e aplicações conforme necessário. Exemplos incluem Amazon EC2, Google Compute Engine e Microsoft Azure Virtual Machines.

A principal diferença entre esses modelos está no nível de responsabilidade do usuário: no SaaS, tudo é gerenciado pelo provedor; no PaaS, o usuário gerencia apenas o desenvolvimento da aplicação; e no IaaS, o usuário tem controle total sobre a infraestrutura, mas ainda depende da nuvem para provisionamento dos recursos.

A Internet

A Internet é uma rede de computadores que interconecta centenas de milhões de dispositivos ao redor do mundo. Esses dispositivos, chamados de sistemas finais ou hospedeiros, incluem desde PCs e servidores até dispositivos móveis, sensores e eletrodomésticos inteligentes. A Internet é, essencialmente, uma "rede de redes", interligando provedores de serviços de Internet (ISPs) de diferentes níveis, desde locais até globais.

Para possibilitar essa comunicação global, a Internet opera com um conjunto de protocolos padronizados, sendo os principais o TCP (Transmission Control Protocol) e o IP (Internet Protocol), que definem a forma como os pacotes de dados são enviados e recebidos. Esses protocolos são documentados em padrões chamados RFCs (Request for Comments), desenvolvidos pela IETF (Internet Engineering Task Force).

Além de sua estrutura técnica, a Internet pode ser vista como uma infraestrutura que fornece serviços para aplicações distribuídas, como e-mail, redes sociais, jogos online, VoIP e streaming de vídeo. Esses serviços são executados em sistemas finais, enquanto a infraestrutura da Internet fornece os meios para a troca de informações.

Intranet e Extranet

A Intranet é uma rede privada usada dentro de uma organização. Baseia-se nas mesmas tecnologias da Internet, mas seu acesso é restrito a funcionários ou membros autorizados da organização. As intranets são frequentemente usadas para compartilhar informações, documentos e sistemas internos de uma empresa.

Já a Extranet é uma extensão da intranet que permite o acesso a usuários externos, como clientes, fornecedores ou parceiros de negócios. O acesso à extranet é geralmente protegido por autenticação e criptografia para garantir a segurança das informações compartilhadas.

Os termos Intranet e Extranet são usados para diferenciar redes privadas organizacionais do conceito mais amplo de LAN (Local Area Network). Embora uma Intranet normalmente funcione dentro de uma LAN, nem toda LAN é uma Intranet.

Quando falamos de Intranet estamos nos referindo ao uso da rede dentro de uma organização para fornecer serviços internos (como portais corporativos, compartilhamento de arquivos e sistemas internos). Ela pode operar dentro de uma LAN, mas o termo destaca seu propósito e aplicações internas. Já a Extranet se expande para permitir o acesso de usuários externos (clientes, fornecedores). Isso envolve medidas adicionais de segurança, como autenticação e criptografia.

Redes Confiáveis

As redes de computadores desempenham um papel essencial na comunicação moderna, exigindo características que garantam sua confiabilidade. Para que uma rede seja considerada confiável, ela deve apresentar tolerância a falhas, escalabilidade, qualidade de serviço (QoS) e segurança.

Tolerância a Falhas

A tolerância a falhas refere-se à capacidade de uma rede continuar operando mesmo diante de falhas em seus componentes. O gerenciamento de falhas pode ser classificado em duas abordagens principais:

Reativo: Detecta, isola e corrige falhas depois que ocorrem. Isso pode incluir protocolos de roteamento dinâmico, que redirecionam o tráfego automaticamente quando um link falha.

Proativo: Emprega técnicas para prever e evitar falhas antes que impactem o funcionamento da rede. Isso pode ser feito por meio de monitoramento contínuo e manutenção preventiva.

Escalabilidade

A escalabilidade de uma rede está relacionada à sua capacidade de crescer sem comprometer o desempenho. Em arquiteturas como as redes P2P (Peer-to-Peer), a escalabilidade é maior, pois os recursos aumentam à medida que novos nós entram na rede. Em contrapartida, a arquitetura cliente-servidor pode enfrentar gargalos quando a demanda excede a capacidade do servidor central.

Qualidade de Serviço (QoS)

A QoS é essencial para garantir que certos tipos de tráfego, como voz e vídeo, tenham prioridade sobre outros dados menos sensíveis à latência. Entre as principais técnicas utilizadas para assegurar a qualidade de serviço, destacam-se:

Reserva de largura de banda: Alocação de recursos específicos para aplicações críticas.

Marcação de pacotes: Identificação do tráfego prioritário para tratamento diferenciado.

Escalonamento de pacotes: Uso de algoritmos que priorizam a transmissão de pacotes mais importantes.

Segurança

A segurança da rede é fundamental para proteger dados e infraestruturas contra acessos não autorizados, ataques e interceptações. Algumas das principais técnicas de segurança incluem:

Criptografia: Protege os dados contra interceptação e adulteração.

Autenticação: Garante que apenas usuários e dispositivos autorizados possam acessar a rede.

Integridade de mensagens: Utiliza algoritmos para verificar se os dados não foram alterados durante a transmissão.

Firewalls e VPNs: Criam barreiras de proteção contra acessos não autorizados e garantem comunicações seguras.

Esses aspectos são fundamentais para a construção de redes confiáveis, garantindo disponibilidade, desempenho e proteção dos dados em ambientes de comunicação modernos.

Protocolos

As redes de computadores sempre dependeram de protocolos para padronizar a comunicação entre dispositivos. Um protocolo define regras e procedimentos para a transmissão de dados, garantindo que diferentes dispositivos possam se comunicar de maneira eficiente e confiável. Desde as primeiras redes até as mais modernas, os protocolos desempenham um papel essencial.

Fontes

https://www.geeksforgeeks.org/history-of-internet/

https://edtechmagazine.com/higher/article/2013/11/history-internet-and-colleges-built-it